Intel создаёт группу по разработке дискретных GPU и нанимает Раджу Кодури»

В четверг вечером корпорация Intel объявила о создании Core and Visual Computing Group, подразделения по разработке дискретных графических процессоров для игровых ПК, а также ускорителей вычислений для суперкомпьютеров и различных перспективных приложений. Новую группу возглавит известный специалист Раджа Кодури (Raja Koduri), успевший поработать в ATI, Apple и AMD Radeon Technologies Group. Сам факт того, что в Intel решили вернуться к созданию дискретных графических процессоров в третий раз, говорит о том, что компания существенно меняет стратегию на нескольких рынках.

«Раджа является одним из самых опытных, новаторских и уважаемых визионеров в области графических и системных архитектур в индустрии и ещё одним примером того, как лучшие таланты присоединяются к Intel,» — сказал Мурти Рендучинтала (Murthy Renduchintala), президент группы Client and Internet of Things Business & Systems Architecture Group (CISA). «У нас есть захватывающие планы по активному расширению наших вычислительных и графических возможностей с использованием нашего всеобъемлющего портфеля интеллектуальной собственности. С Раджей во главе Core and Visual Computing Group мы добавим в наш портфель непревзойдённые возможности, продвинем нашу стратегию в области вычислений и графики и, впоследствии, станем движущей силой революции обработки данных».

Intel возвращается на рынок дискретных GPU

Принимая во внимание характер анонса, трудно ожидать, что Intel раскроет перспективный план по разработке графических и вычислительных технологий, который будет реализовываться под руководством господина Кодури. Тем не менее, пресс-релиз Intel раскрывает ряд деталей о характере будущих решений компании.

Ключевой задачей Раджи Кодури в Intel станет создание семейства высокопроизводительных дискретных графических решений для различных приложений. Данные решения будут базироваться на унификации различных архитектур и интеллектуальной собственности Intel, а конечные продукты будут использоваться для обработки графики, суперкомпьютерных вычислений, искусственного интеллекта и ряда других перспективных направлений.

Хотя задача господина Кодури кажется однозначной, её исполнение означает существенный сдвиг в стратегии Intel по целому ряду направлений, а потому есть смысл вспомнить подходы Intel к разработке GPU и суперкомпьютерным ускорителям.

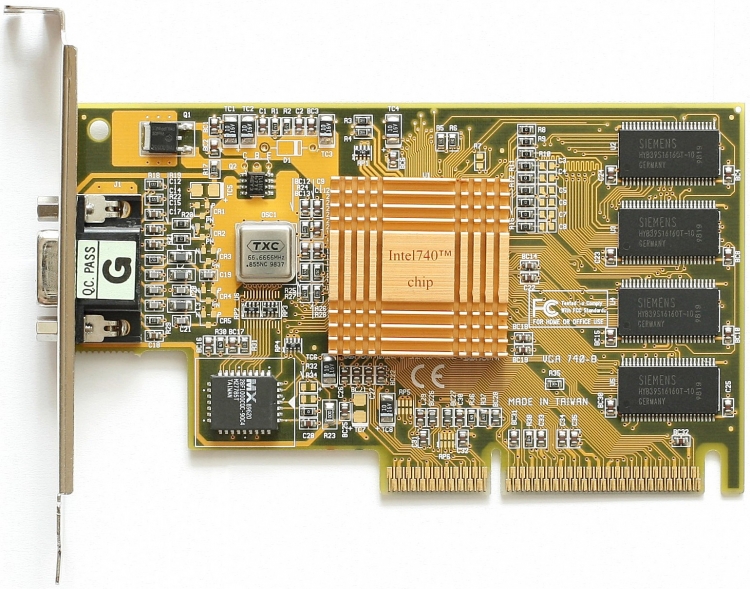

Intel 740 и графические адаптеры стоимостью похода в кафе

Глядя на взрывной рост популярности графических ускорителей для игровых ПК в 1990-х годах прошлого века, в Intel осознали, что подобные микросхемы могут стать новым рынком сбыта, а потому корпорация должна выпустить собственный графический процессор. Поскольку у Intel не было собственной команды разработчиков графических адаптеров, то для работы над проектом Auburn компания решила объединить усилия с другими игроками рынка — Real3D (изначально подразделение General Electric, затем — Lockheed Martin) и Chips and Technologies.

Auburn появился на свет в начале 1998 года под именем Intel 740, а его главной особенностью стало использование инновационной по тем временам шины AGP. В теории AGP позволяла хранить текстуры в системной памяти, тем самым снижая требования к объёму оперативной памяти на графическом адаптере и его себестоимость. На практике хранить текстуры в системной памяти было невыгодно с точки зрения производительности, драйверы Intel 740 оказались очень несовершенны, а конкуренция со стороны традиционных разработчиков графических адаптеров столь серьёзной, что в Intel приняли решение прекратить продажи i740 осенью 1999 года. Чуть позже Intel попыталась выпустить ещё один дискретный графический процессор (Intel 752), но не смогла сделать его сколько-то массовым.

Неудачи i740 и i752 показали Intel, что компания не может выдержать конкуренции с ATI и NVIDIA на рынке видеокарт. Однако имеющиеся на тот момент возможности полупроводникового гиганта в области интеграции, производства и продаж подсказали Intel, что она в состоянии создавать дешевые интегрированные графические решения для недорогих ПК. Таким образом, в недрах Intel родилось подразделение под руководством Тома Пиаццы (Tom Piazza), которое занималось разработкой графических процессоров Graphics & Media Accelerator (GMA), чья стоимость для конечных пользователей была равна цене похода в кафе. Поскольку Intel жёстко ограничивала развитие своих встроенных GPU транзисторным бюджетом, размерами на кристалле и устаревшими технологическими процессами производства, GMA имели довольно скромные возможности и посредственную репутацию.

Через несколько лет в Intel пожалели о таком подходе, но до того времени недорогая графика Intel стала весьма популярной среди желающих снизить себестоимость производителей ПК.

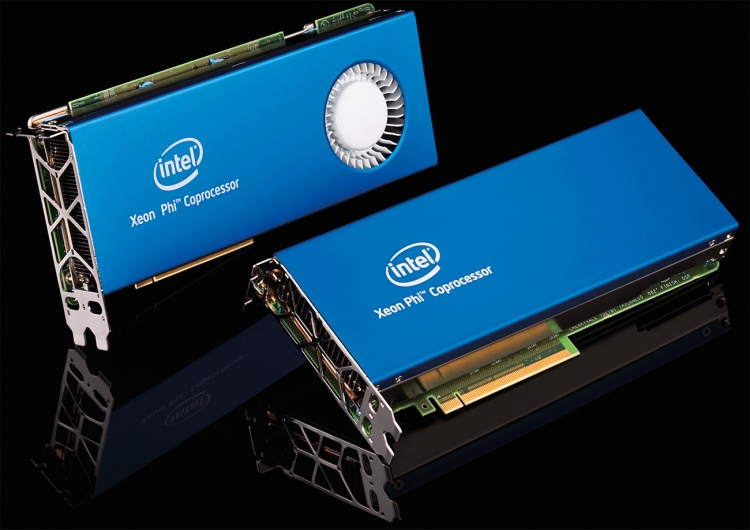

Intel Larrabee: x86 от игрового ПК до суперкомпьютера

Шло время, в начале 2000-х годов в отрасли заговорили о том, что GPU можно использовать для определённых вычислений общего назначения в суперкомпьютерах, получив преимущество от их «параллельности». Помимо GPU, на рынке появлялись гетерогенные (Niagara/Sun UltraSPARC T1) и гомогенные (Cell BE) многоядерные процессоры, также направленные в т. ч. на суперкомпьютеры. Разумеется, как GPU, так и многоядерные CPU представляли прямую угрозу для Intel. Помимо этого, несмотря на то, что интегрированные GPU Intel использовались в огромном количестве недорогих ПК, рынок дорогих дискретных GPU рос, равно как средняя стоимость графических карт. Таким образом, в 2005 году руководство Intel приняло решение возобновить работу над дискретными графическими процессорами, но при этом не пытаться улучшить архитектуру GMA до уровня дискретных GPU ATI и NVIDIA, а создать нечто иное. Впоследствии это стало проектом Larrabee.

Основные требования к разрабатываемой GPU-архитектуре были просты: большое количество вычислительных ядер общего назначения на базе архитектуры x86, высокая тактовая частота, максимальное количество операций с плавающей запятой в секунду (TFLOPS), минимальное количество специфических для GPU блоков. Учитывая требования и многоцелевой характер будущего продукта, изначально проект получил название SMAC (Simple, Massive Array of Cores — простой огромный массив ядер). В руководстве Intel считали, что «гибкие» высокочастотные x86-ядра смогут выполнять те же задачи, что и специализированное аппаратное обеспечение в GPU с приемлемой скоростью, их количество даст возможность максимизировать вычислительную мощность для суперкомпьютеров, а совместимость с x86 облегчит работу HPC-программистов, привыкших к Intel Xeon.

По словам разработчиков, для эмуляции аппаратных возможностей GPU на 62-ядерном графическом процессоре Larrabee запускали операционную систему FreeBSD и программу DirectXGfx. Последняя не только позволяла играть в DirectX 11-игры (разумеется, на обычной Windows-системе), но и добавлять Larrabee новые возможности. К сожалению, такой подход не позволил Larrabee показывать конкурентоспособную производительность в сравнении с AMD Radeon и NVIDIA GeForce, что и послужило причиной отказа Intel от выпуска Larrabee в качестве GPU. Тем не менее, архитектура Larrabee была использована для сопроцессоров, а потом и процессоров Xeon Phi, призванных конкурировать с ускорителями NVIDIA Tesla. Глядя на пиковую производительность топовых Xeon Phi 7290 (3,5 FP64 TFLOPS) и NVIDIA Tesla P100 (4 – 4,6 FP64 TFLOPS для PCIe карты, 4,7 – 5,3 FP64 TFLOPS для NVLink ускорителя), довольно очевидно, что сегодняшний Xeon Phi на базе x86 не может противостоять GPU на основе ядер с современной проприетарной архитектурой. Можно констатировать, что на сегодняшний день Larrabee не преуспел ни в одной из своих изначальных задач: он не стал быстрым GPU и едва ли может конкурировать с NVIDIA на рынке суперкомпьютеров.

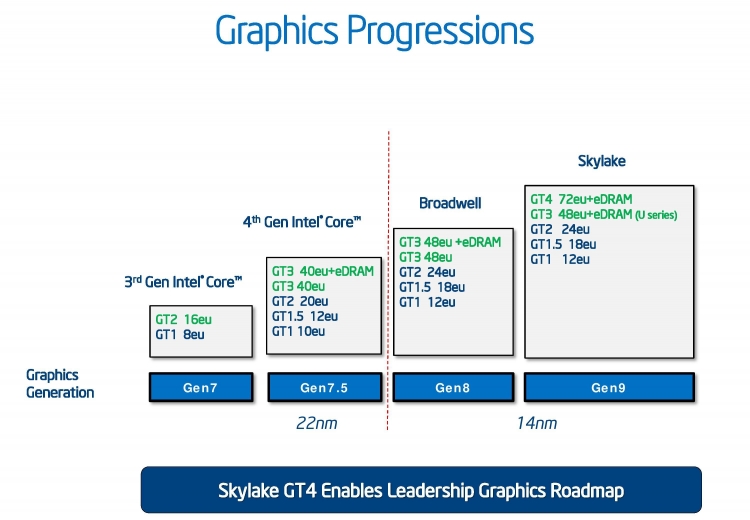

HD и Iris Graphics: гадкий утёнок превращается в лебедя

Larrabee был не единственным графическим проектом Intel, стартовавшим в середине 2000-х годов. Как несложно вспомнить, операционные системы и графические интерфейсы становились всё более требовательными к ресурсам GPU с появлением Apple Mac OS X (2000), Microsoft Windows Vista (2006), Apple iPhone OS (2007) и других. В какой-то момент Intel не смогла убедить Apple использовать её микросхемы в своих мобильных устройствах вследствие того, что у компании не было сколько-то мощных встроенных GPU. Кроме того, Стив Джобс (Steve Jobs) настоятельно требовал от Пола Отеллини (Paul Otellini, исполнительный директор Intel c 2005 по 2013 год) увеличить производительность интегрированных графических процессоров (iGPU), поскольку использование дискретных GPU становилось всё более проблематичным в мобильных ПК.

Проигрыш многомиллионного контракта, а также настойчивые требования важного партнёра сделали своё дело: в 2007 году господин Отеллини объявил о планах увеличить производительность встроенных GPU в 10 раз к 2010 году. Именно в этот момент настал золотой час группы Тома Пиаццы, некогда разработавшей Intel 740.

Получив финансирование, транзисторный бюджет, достаточное место на кристалле, а затем и передовые технологии производства (вследствие перемещения iGPU в процессор), команда смогла разработать графическое решение, которое превосходило производительность iGPU образца 2007 года в 25 раз. В последующие годы производительность интегрированных графических процессоров Intel росла не только благодаря улучшениям в области архитектуры, но и появлению более мощных версий этих iGPU c большим количеством исполнительных устройств (EU, execution units). Так, если наиболее мощное графическое ядро класса GT3 в процессоре поколения Haswell обладало 40 EU, то CPU поколения Skylake уже могут похвастаться iGPU класса GT4 с 72 EU. Как показала практика партнёрства Intel c AMD в области интеграции дискретного Radeon в один корпус с процессором Kaby Lake, Intel готова идти ещё дальше, чтобы представить своим пользователям более высокую производительность.

Раджа Кодури в Intel: чего ожидать?

Принятие на работу ключевого сотрудника конкурента, с которым только что был заключен контракт на поставку важного компонента, говорит о том, насколько специалист уровня господина Кодури необходим Intel.

Как видно, в отличие от начала 2000-х годов, в Intel более не считают графические ускорители уделом любителей игр и развлечений. Быстрая эволюция iGPU компании последних лет подтверждает это. Судя по всему, Intel готова инвестировать в графические процессоры, а потому Раджа Кодури получит все необходимые ему ресурсы. Сам факт принятия на работу специалиста такого уровня говорит об очень серьёзных намерениях.

Примечательно, что в Intel говорят об унификации архитектур и интеллектуальной собственности на фоне того, что Xeon Phi на базе x86 не может конкурировать с NVIDIA Tesla в том, что касается производительности. Неизвестно, означает ли фраза Intel об унификации, что компания планирует отказаться от x86-ядер в решениях для суперкомпьютеров, однако едва ли это стало бы удивительным развитием событий.

Пожалуй, самый главный вопрос, на который пока нет ответа, это то, когда именно Intel планирует выпустить свой новый дискретный GPU. В случае, если у компании нет уже готовой архитектуры, способной масштабироваться от небольшого iGPU для ноутбука до дискретного графического процессора размером 550 мм2 и более, то работа над дискретным GPU Intel потребует нескольких лет. Таким образом, едва ли мы увидим плоды деятельности Раджи Кодури ранее 2022 года. Если же текущая (Gen 9.5) или будущая (Gen 10, Gen 11) графическая архитектура Intel (чья разработка уже завершена) способна масштабироваться и показывать производительность сравнимую с будущими решениями AMD и NVIDIA, мы вполне можем рассчитывать увидеть дискретный GPU компании уже в 2019–2020 году (но не раньше, иначе в партнёрстве Intel c AMD не было бы смысла).

Стоит помнить, что поскольку в описании рабочих задач господина Кодури значится не только проектирование нового GPU, но и унификация различных архитектур и интеллектуальной собственности Intel, очень вероятно, что мы увидим несколько поколений продукции для разных приложений, прежде чем поставленная Intel задача будет выполнена.